Eclosión tecnológica

Entre el 'hype' y el miedo: los intereses comerciales marcan el frenesí de la inteligencia artificial

El alboroto publicitario y la exageración del temor a la expansión de la IA aceleran la estrategia de los gigantes tecnológicos de Silicon Valley para hacerse con el control de una de las tecnologías llamadas a marcar el futuro

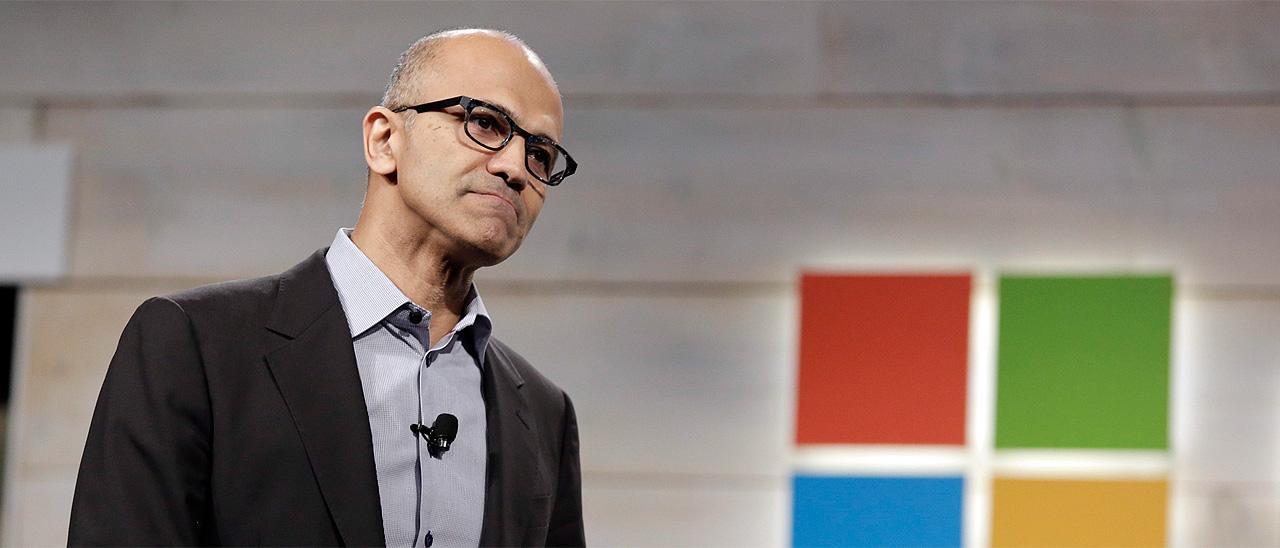

Satya Nadella, consejero delegado de Microsoft. / Reuters

Carles Planas Bou

"La gente debería alegrarse de que estemos un poco asustados". Hace un mes, Sam Altman, director ejecutivo de OpenAI, confesaba en televisión el supuesto temor por su creación, ChatGPT. Esta tecnología, añadía, puede ser "la mayor que ha desarrollado la humanidad". Sus palabras no eran espontáneas, sino parte de una estudiada estrategia comercial que está marcando el frenético despliegue de la inteligencia artificial (IA). El miedo y la fascinación son los dos vectores de una carrera entre grandes empresas tecnológicas cuyas consecuencias son impredecibles.

En los últimos cuatro meses, estos sistemas han pasado de estar confinados en los laboratorios de gigantes del sector a estar en todos lados, mostrando al gran público el potencial de la IA. Millones de personas han usado la capacidad de simular el razonamiento humano de ChatGPT para generar todo tipo de textos. Microsoft, impulsora de OpenAI, está integrando su herramienta en su buscador y casi todos sus servicios de oficina, forzando a rivales como Google —que, irónicamente, inventó la tecnología en la que se basan estos chatbots— a maniobrar para seguirle los pasos y no quedarse atrás.

Salto técnico y promocional

El salto, apuntan los expertos, no ha sido tanto técnico, sino promocional. "Su apertura al gran público es uno de los mayores experimentos sociales que se han hecho", explica Nerea Luis, doctora en ciencias de la computación. "Están jugando con el alboroto como estrategia de marketing premeditada para posicionarse como diseñadores del futuro".

"Están jugando con el alboroto como estrategia de marketing premeditada para posicionarse como diseñadores del futuro"

Su precoz adopción ha convertido la IA generativa en la tecnología de moda. Desde el 2020, la inversión de capital riesgo en ese campo se ha disparado un 425% hasta superar los 2.100 millones de dólares, según datos de Pitchbook. Eso irá a más con GPT4, la última evolución del modelo de lenguaje que sustenta ChatGPT y que quiere ser la plataforma sobre la que se construirá una nueva generación de aplicaciones. "Esa promesa generará un efecto llamada a los desarrolladores y abrirá las puertas a un montón de oportunidades positivas para mejorar la ciencia y la educación", cree el analista tecnológico Antonio Ortiz.

Bombo publicitario

Cada semana se amontonan anuncios de nuevas apps, demostraciones de sus capacidades y estudios que dicen pronosticar el impacto de la IA. Un alud de ruido del que la industria se aprovecha para impulsar el 'hype' (bombo publicitario) de su tecnología estrella. OpenAI ha publicado estudios en los que testea a su chatbot con exámenes para humanos y otros en los que asegura que afectará a un 80% de los profesionales. "Aunque contienen preocupaciones válidas, son notas de prensa disfrazadas de 'papers' pseudocientíficos para generar titulares y anestesiar la crítica", denuncia Ariel Guersenzvaig, profesor de ELISAVA experto en ética del diseño y la tecnología, que equipara esa práctica a la seguida por las industrias del petróleo y del tabaco.

Aunque la tecnología se vista de magia para venderse, detrás siempre hay un truco. Los grandes modelos de lenguaje que dan 'vida' a ChatGPT son sistemas que usan cálculos probabilísticos para construir frases en base al océano de datos que extraen de internet. Son como loros: pueden generar un discurso plausible con sentido, pero sin entender su significado. "Son modelos asombrosos, pero factualmente no puedes creer lo que dicen porque siguen difundiendo falsedades", advierte Ortiz. Esos errores han llevado a Microsoft y a Google a corregir sus chatbots, pero también a otros actores en competición como Meta —propietaria de Facebook e Instagram— o Snap.

"Son modelos asombrosos, pero factualmente no puedes creer lo que dicen porque siguen difundiendo falsedades"

Narrativa ideológica

El temor al impacto que esos y otros fallos puedan tener en la sociedad llevó a miles de personalidades a pedir una moratoria de seis meses en el entrenamiento de las IA más potentes. Aunque incluye preocupaciones legítimas, la carta pública firmada por Elon Musk y otros ha despertado muchas críticas, pues habla de "mentes no humanas que podrían reemplazarnos" y de "perder el control de nuestra civilización", pura ciencia-ficción.

La carta abierta fue publicada por el Future of Life Institute, organización promotora del largoplacismo, una ideología influyente en las élites de Silicon Valley que, según reputadas expertas, “fantasea con una utopía o un Apocalipsis de la IA”. Esa mentalidad, que se expone en propuestas como mejorar genéticamente los humanos o colonizar el espacio, merma el sentido crítico y “atribuye erróneamente agencia” a ChatGPT, lo que permite a sus constructores esquivar su responsabilidad.

"Es una distracción para no hablar de la burrada de datos que usa ChatGPT, de su ingente coste energético y de su impacto humano en África (...) Estamos siguiendo un discurso blanco de más de 400 años que naturaliza la tecnología como algo inevitable y que es colonialismo puro y duro", denuncia Lorena Jaume-Palasí, experta en IA, filosofía del derecho y ética de la tecnología. "La idea del Terminator exagera las capacidades de la IA y eso desplaza los riesgos éticos reales", añade Guersenzvaig.

Concentración de poder

Los expertos consultados se muestran preocupados porque esta nueva fiebre del oro refuerza la concentración de poder en manos de Google, Microsoft, Meta y Amazon. "Están intentando crear infraestructuras esenciales de las que dependan todos los sectores", añade Jaume-Palasí, asesora del Instituto Max Planck, una de las instituciones científicas más prestigiosas del mundo.

Durante años, la riqueza de los gigantes tecnológicos les ha permitido copar la investigación científica de la IA y enfocarla a sus intereses de negocio, decidiendo los marcos del debate ético. Aunque hasta ahora habían compartido mucha información de su desarrollo, OpenAI ha dejado de ser abierta con GPT4 y ha adoptado una opacidad que las otras empresas podrían seguir. "Eso será bueno para sus objetivos comerciales, pero muy malo para la ciencia", lamenta Luis.

Los expertos critican que, mientras lanzan al gran público herramientas cuyo impacto es impredecible, estas empresas también están adelgazando los equipos éticos encargados de estudiar esos riesgos. En los últimos meses lo han hecho Microsoft, Twitter y Twitch. La científica computacional Timnit Gebru, despedida en 2020 como líder de la división ética en IA de Google, ve en esos equipos una “fachada” de la que las compañías se desprenden cuando los resultados van en contra de sus intereses o cuando hay despidos.

Silicon Valley ha vuelto a maniobrar siguiendo el dogma 'move fast, break things' ("muévete rápido, rompe cosas"). Ahora nos encontramos en la primera fase, de despliegue y adopción vertiginosa. La segunda también llegará, lo que aún no sabemos es en qué forma. En un alarde de sinceridad y arrogancia poco habitual, el director ejecutivo de Microsoft, Satya Nadella, ha celebrado el éxito de una estrategia empresarial que parece haber acabado con la precaución en el sector: "Quiero que la gente sepa que les hemos hecho bailar". Se refería a Google, pero quizás también a todos nosotros.

Suscríbete para seguir leyendo

- El cambio climático trae un tipo inédito de raya a Galicia

- Muere Itxaso Mardones, reportera de Gloria Serra en 'Equipo de investigación', a los 45 años

- El chalet de Vigo en el que vivía un jugador del Celta esquiva la piqueta

- Los mejillones en escabeche caseros con los que no volverás a la conserva

- Bono Activa Comercio 2024: cómo se solicita y en qué tiendas se puede utilizar

- El Parlamento de Galicia reclama que se suprima la obligación de registrar los gallineros de autoconsumo

- Caen dos históricos atracadores por el asalto bancario del botín de 300.000 euros de Gran Vía

- La familia real británica se está preparando para el funeral de Carlos III: "Se encuentra realmente muy mal