Tecnologías disruptivas

Llega la Inteligencia Artificial que puede retratar lo que estamos pensando

Es capaz de interpretar señales cerebrales y de poner en evidencia nuestra imaginación

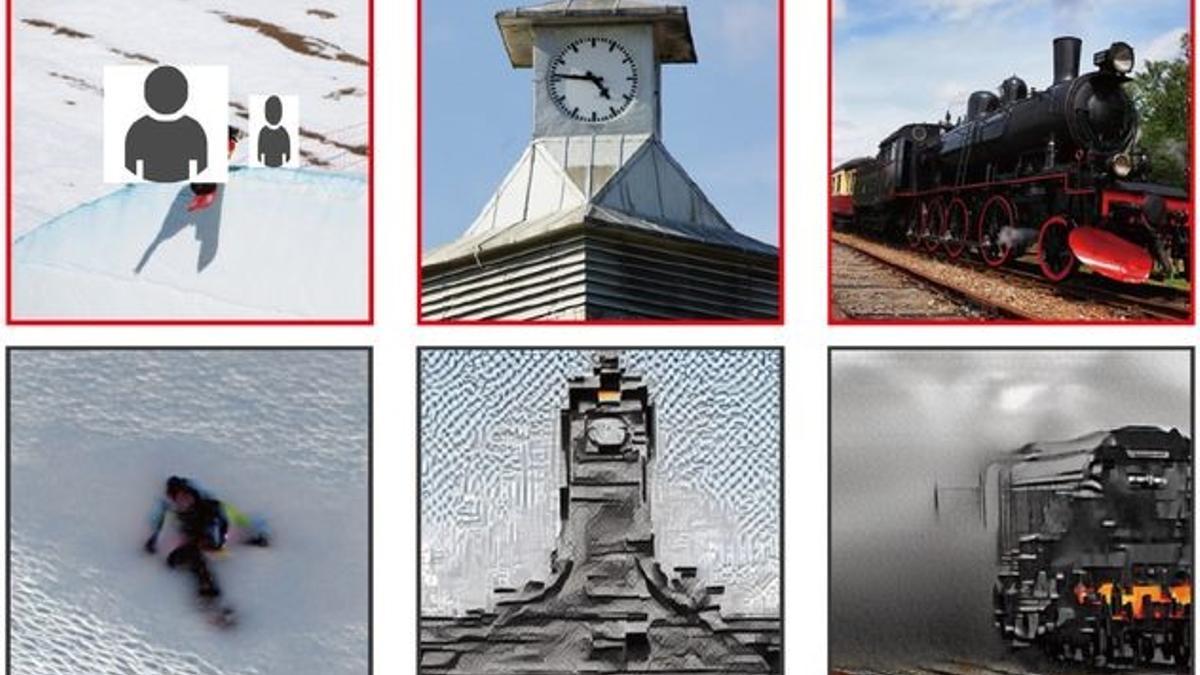

Imágenes presentadas (fila superior) e imágenes reconstruidas por la IA (fila inferior). / Yu Takagi/Shinji Nishimoto.

Redacción T21

Un sistema de IA ha sido capaz de reproducir las imágenes de paisajes, objetos y cosas que estaban en el pensamiento de cuatro personas. Aprendió a interpretar sus señales cerebrales y consiguió una precisión del 80 por ciento.

Investigadores de la Universidad de Osaka en Japón han instruido a un sistema de Inteligencia Artificial (IA) para generar imágenes de lo que una persona está pensando con una precisión del 80 por ciento. Los resultados de este experimento se han publicado en bioRxiv.

El experimento consistió en mostrar 10.000 imágenes de paisajes, objetos y personas, a cuatro voluntarios mientras sus cerebros eran escaneados mediante imágenes por resonancia magnética funcional (fMRI).

Esta técnica refleja las regiones cerebrales que están activas cuando se está realizando una tarea determinada: en el caso del experimento, mientras los voluntarios veían las imágenes que les mostraban.

A continuación, las grabaciones de la actividad cerebral de esas sesiones fueron introducidas en un sistema de IA para que aprendiera a reconocer cómo el cerebro de cada participante procesaba las imágenes mostradas durante el experimento.

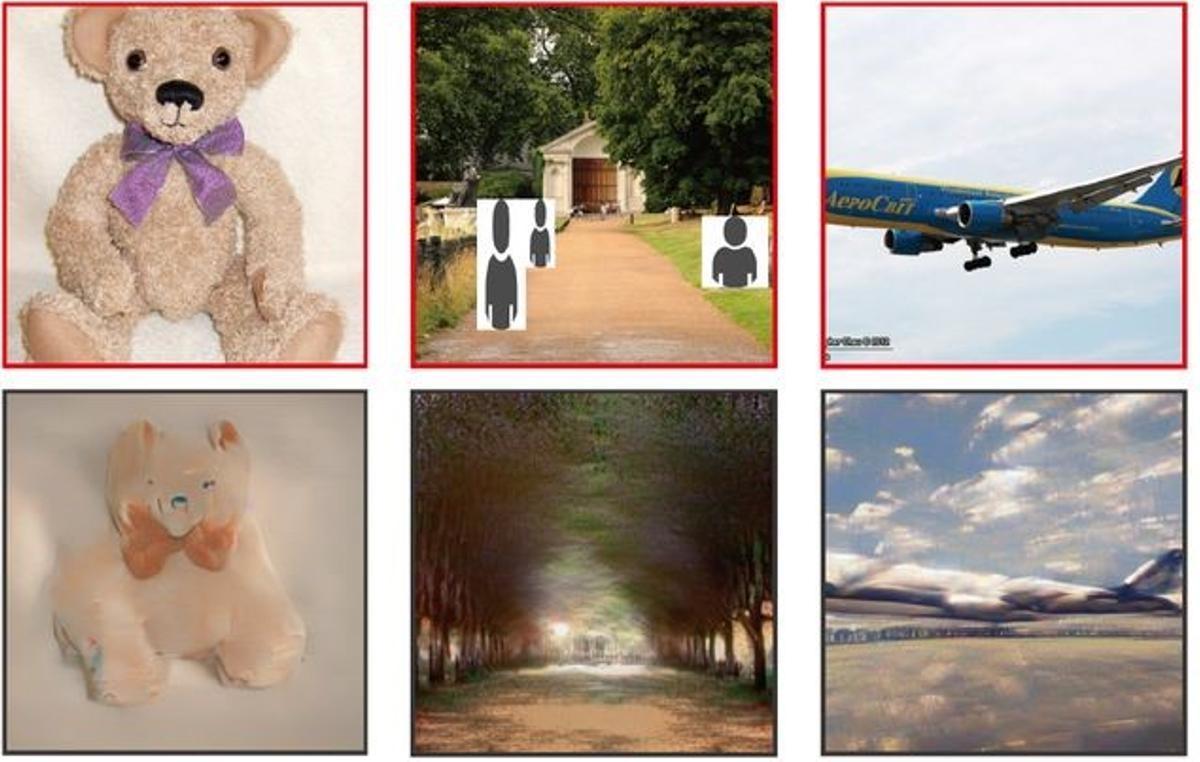

Más fotos presentadas (fila superior) y creadas por la IA (fila inferior). / Yu Takagi/Shinji Nishimoto.

Generador de imágenes

Los investigadores trabajaron con un sistema de IA ya existente, conocido como Stable Diffusion: es un generador automático de imágenes a partir de descripciones que recibe en lenguaje natural. Lo modificaron para que la generación de imágenes se hiciera a partir de escaneos cerebrales, en vez de mediante lenguaje natural.

Usando alrededor del 90 por ciento de los datos de imágenes cerebrales, los investigadores entrenaron mediante aprendizaje automático a Stable Diffusion para que estableciera vínculos entre los datos de fMRI de una región del cerebro que procesa señales visuales, llamada corteza visual temprana, y las imágenes que las personas estaban viendo.

Una vez que la IA fue entrenada, pudo interpretar la actividad cerebral y generar reconstrucciones de las imágenes bastante precisas de lo que habían estado viendo los voluntarios.

Aunque en algunos casos la IA interpretó mejor la actividad cerebral de unas personas que de otras, el experimento mostró claras similitudes entre los objetos, colores y composiciones de cada imagen y las reconstrucciones realizadas por la IA.

Este desarrollo representa solo un primer paso de lo que puede conseguirse, ya que los creadores de esta tecnología, Shinji Nishimoto y Yu Takagi, piensan que se podría usar en el futuro para que una IA pueda ensamblar imágenes directamente de la imaginación de una persona.

Aplicaciones y peligros

Cuando eso ocurra, podría facilitar potentes interfaces cerebro-ordenador tremendamente útiles tanto en entornos clínicos como recreativos.

Estos interfaces podrían ser especialmente valiosos para las personas con discapacidades motoras, ya podrían “pintar” cuadros de paisajes o retratos personas que solo están en su imaginación, o participar en videojuegos, sin mover un dedo.

Sin embargo, también existen riesgos asociados con esta tecnología, particularmente problemas de privacidad y seguridad: los datos recopilados del cerebro de las personas podrían usarse para reconstruir pensamientos internos y privados, reconocen los investigadores, por lo que habría que tomar medidas de seguridad para prevenir usos fraudulentos.

Medio plazo

De todas formas, esta tecnología no está madura todavía para convertirse en aplicaciones prácticas al alcance de cualquiera.

El sistema requiere una amplia capacitación utilizando voluminosos y costosos equipos de imágenes, por lo que la reconstrucción automática de lo que una persona está pensando está todavía lejos de la realidad, asumen los investigadores.

Consideran que la principal aportación de su estudio es que revela las similitudes y diferencias entre lo que interpreta el cerebro humano, por un lado, y la IA, por otro.

También pone de manifiesto el potencial que podría tener una mayor colaboración entre los técnicos de la IA y los neurocientíficos, por las expectativas que ha planteado su desarrollo.

Este estudio es el último ejemplo de cómo los modelos de IA pueden trabajar con el cerebro humano para recrear imágenes, concluyen los investigadores.

Referencia

High-resolution image reconstruction with latent diffusion models from human brain activity. Yu Takagi, Shinji Nishimoto. bioRxiv, March 11, 2023. DOI: https://doi.org/10.1101/2022.11.18.517004

- Revelan el misterio del árbol tropical que camina

- La acidez cerebral podría estar relacionada con múltiples trastornos neurológicos

- Descubren cómo Plutón consiguió su corazón

- Descubren el pan más antiguo en Turquía: tiene 8.600 años

- Los abrazos alivian la ansiedad y la depresión, según un nuevo estudio

- La geometría del caos, ¿futuro de la arquitectura?

- En el caso de los caracoles, el huevo fue lo primero

- Revelan la primera molécula fractal en la naturaleza